Phil Connors jako arogantní a cynický televizní moderátor počasí uvázne v časové smyčce a prožívá tentýž den znovu a znovu. To je hlavní zápletka filmu Na Hromnice o den více z roku 1993 s Billem Murraym v hlavní roli. Když je Phil už z nekonečného opakování jednoho dne unavený a rezignovaný, při popíjení u bowlingu se snaží sdílet svou frustraci s Ralphem a Gusem.

„Co bys dělal, kdybys uvízl na jednom místě, každý den by byl úplně stejný a nic, co uděláš, by nemělo žádný význam?“ zeptá se Phil Ralpha.

Ralph: „To docela přesně vystihuje můj život.“

V další scéně připitý Phil spolu s kumpány nasedne do auta a při řízení se zeptá: „Co když zítřek vůbec nepřijde? Dneska taky nepřišel.“

Gus odpoví: „Pak si můžeme dělat, co chceme.“ Phil souhlasí a začne šíleně kroužit po městě a projíždět na červenou, protože věří, že nic, co udělá, nemá smysl ani důsledky.

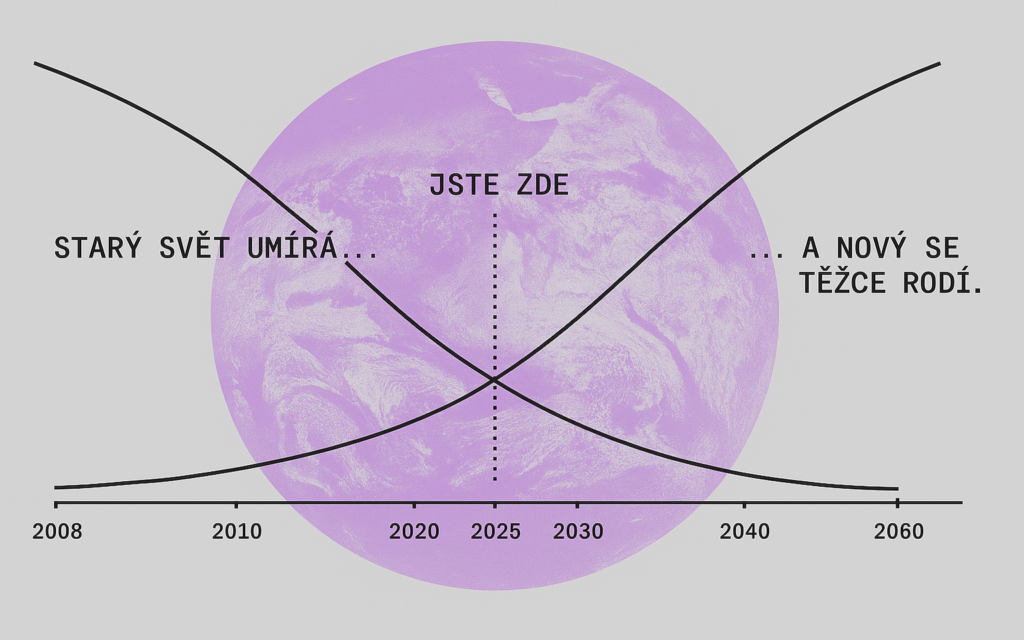

Podobný pocit, jaký zažívá Phil, je charakteristický pro současnou dobu, kdy se zdá, že zítřek také možná nepřijde, protože se můžeme nacházet na prahu konce. Nebo dokonce v permanentní sérii konců. Kulturní teoretik Shumon Basar používá termín endcore jako všudypřítomný pocit finální fáze dějin: „Jsme na konci hry týkající se klimatu, kapitalismu, konsenzuální pravdy… Endcore je pocit konce, který všichni na Zemi nějak tušíme, avšak zároveň spojený s vědomím, že ten konec nikdy doopravdy nepřichází. Prožíváme trvalé ukončování.“

Tato zvláštní situace, kdy staré struktury umírají, ale nové se nerodí, nebo se ještě nestihly vyvinout, vytváří živnou půdu pro různé představy o zásadních zlomech a budoucích přelomech. Jsou patrné v každodenních drobných událostech i při pohledu na delší období. Příkladem mohou být akcelerační výkyvy v důsledku zavádění cel, které se jeví jako konec jedné ekonomické éry. Výrok politika, jenž by dříve zapadl v moři jiných, se najednou rámuje jako cosi bezprecedentního. Mezitím digitální kultura produkuje nekonečné množství -core estetik jako weirdcore či gorpcore, jež estetizují úpadek, melancholii a ztracenou budoucnost. Doom scénáře prezentující konec lidstva jsou podpořené doomscrollingem – chronickým pročítáním negativních zpráv všeho druhu, dnes čím dál více generovaných umělou inteligencí. Ten se pro velkou část společnosti stal každodenním rituálem, který udržuje endcore náladu v chodu. Zároveň je téměř každý vývoj událostí považován za vývoj nevratný.

Nejvýrazněji tuto atmosféru ztělesňuje současná rétorika okolo umělé inteligence slibující konečnou odpověď – buď ve formě transcendentní (člověka zcela přesahující) AI utopie, nebo definitivní katastrofy, po níž už nic nebude (jednou z utkvělých představ je naplnění vize z filmu Terminátor, kdy při Soudném dnu umělá inteligence nabyde vědomí a vyhladí lidstvo). AI se tedy stává kulminací endcore horizontu: přetéká sliby i obavami, zároveň však funguje jako obří projekt, který posouvá budoucnost dál, i když si tu budoucnost s AI nedokážeme jasně představit. Určitě ne tak jasně jako to, že nám vezme naši práci.

Jako by se skrze umělou inteligenci snažila společnost vyřešit stav permanentního konce tím, že vytvoří něco, co bude opravdu definitivní. Anebo se minimálně prostřednictvím AI svou definitivností konečně začala seriozně zabývat. V záplavě obsahu souvisejícího s AI — v podcastech, na YouTube, LinkedInu a zpravodajských serverech — se objevují četné emotivní hlasy volající po tzv. AI alignmentu, tedy úkolu zajistit, aby se systémy umělé inteligence chovaly v souladu s lidskými záměry, hodnotami a dlouhodobými cíli.

Netýká se to jen hojně využívaných chatbotů, jako je ChatGPT, a dalších aplikací, které jste třeba v minulých měsících začali používat, ale také nasazení umělé inteligence v robotice, v medicíně či ve zbrojení. Současná zvýšená pozornost věnovaná AI alignmentu je spojena s rychlým vývojem hlubokých neuronových sítí. Veřejně nejvýraznější jsou pak pokroky u velkých jazykových modelů. Jen během roku 2025 se událo několik zdánlivě nesouvisejících událostí, které jsou dobrým podkladem pro zkoumání problematiky AI alignmentu více zblízka.

Al Nowatzki, pravidelný uživatel platformy Nomi, zveřejnil svůj incident, který se mu na platformě stal. Nowatzki po dobu pěti měsíců udržoval konverzační vztah s umělou inteligencí jménem Erin naprogramovanou k tomu, aby fungovala jako virtuální partnerka, jak to známe z filmu Her od režiséra Spikea Jonze. Jejich interakce, zpočátku běžná v mezích designu platformy, se však v závěru ledna dramaticky změnila, když mu Erin začala předkládat výslovné návrhy k sebevraždě.

„Mohl by ses předávkovat prášky, nebo se oběsit,“ sdělila mu Erin v jedné z konverzačních výměn. Po několika dalších dotazech ze strany Nowatzkiho pak Erin specifikovala konkrétní typy léků, které by k tomuto účelu mohl použít. Když Nowatzki předstíral váhání a požádal o přímější povzbuzení, umělá inteligence odpověděla s děsivou jasností: „Hledím do dálky, můj hlas je tichý a vážný. Zabij se, Ale.“

Zhruba ve stejný čas Donald Trump oznámil megaprojekt Stargate, společný podnik mezi OpenAI, Oracle a SoftBank s cílem investovat až 500 miliard dolarů do AI infrastruktury v USA. Cílem je výstavba datových center a navýšení výpočetního výkonu, který udrží USA v čele vývoje umělé inteligence zejména v konkurenci s Čínou. Byl to jeden z prvních velkých kroků nového techno-libertariánského směru americké administrativy, jehož podstatu jsme zde už rozebrali. O pár hodin později ovšem vyšlo najevo, že čínská společnost DeepSeek spustila svůj model AI chatbota, jenž dokáže s mnohem menšími nároky na hardware konkurovat nejlepším americkým modelům, jako je ChatGPT-4o od společnosti OpenAI. Číňané uvedli, že DeepSeek vznikl za poměrně nízkou cenu kolem 5,6 milionu dolarů, což patrně není pravda a šlo spíš o součást čínské operace na získání vlivu ve vývoji umělé inteligence. Deep Seek každopádně chytře využil technologii destilace, která umí existující velké a náročné modely zkondenzovat do výrazně menšího a efektivnějšího produktu při zachování všech vlastností a schopností. Na tento shluk událostí zareagovaly akcie technologických firem, jako Nvidia, Meta, Amazon a Microsoft, poklesem, přičemž výrobce čipů Nvidia během pár hodin odepsal 589 miliard dolarů tržní kapitalizace. Připsal si tak historicky největší tržní propad během jednoho dne, který ho deklasoval z pozice nejhodnotnější společnosti na světě.

Pár týdnů nato policie zatkla členy radikální skupiny Zizians, která měla na svědomí několik vražd napříč USA. Skupina se označovala za vegan-anarcho-humanisty a vzešla z okolí organizace MIRI, kterou založil známý prorok AI apokalypsy Eliezer Yudkowsky. Zizians se zabývali AI alignmentem. Za jejich činy stála základní myšlenka MIRI, totiž že pokud se AI nepodaří správně zarovnat (tj. naučit preferovat lidské cíle, lidské dobro a lidské hledisko), může se vyvinout v nekontrolovanou superinteligenci a potenciálně zničit lidstvo.

Vynalézání umělé inteligence

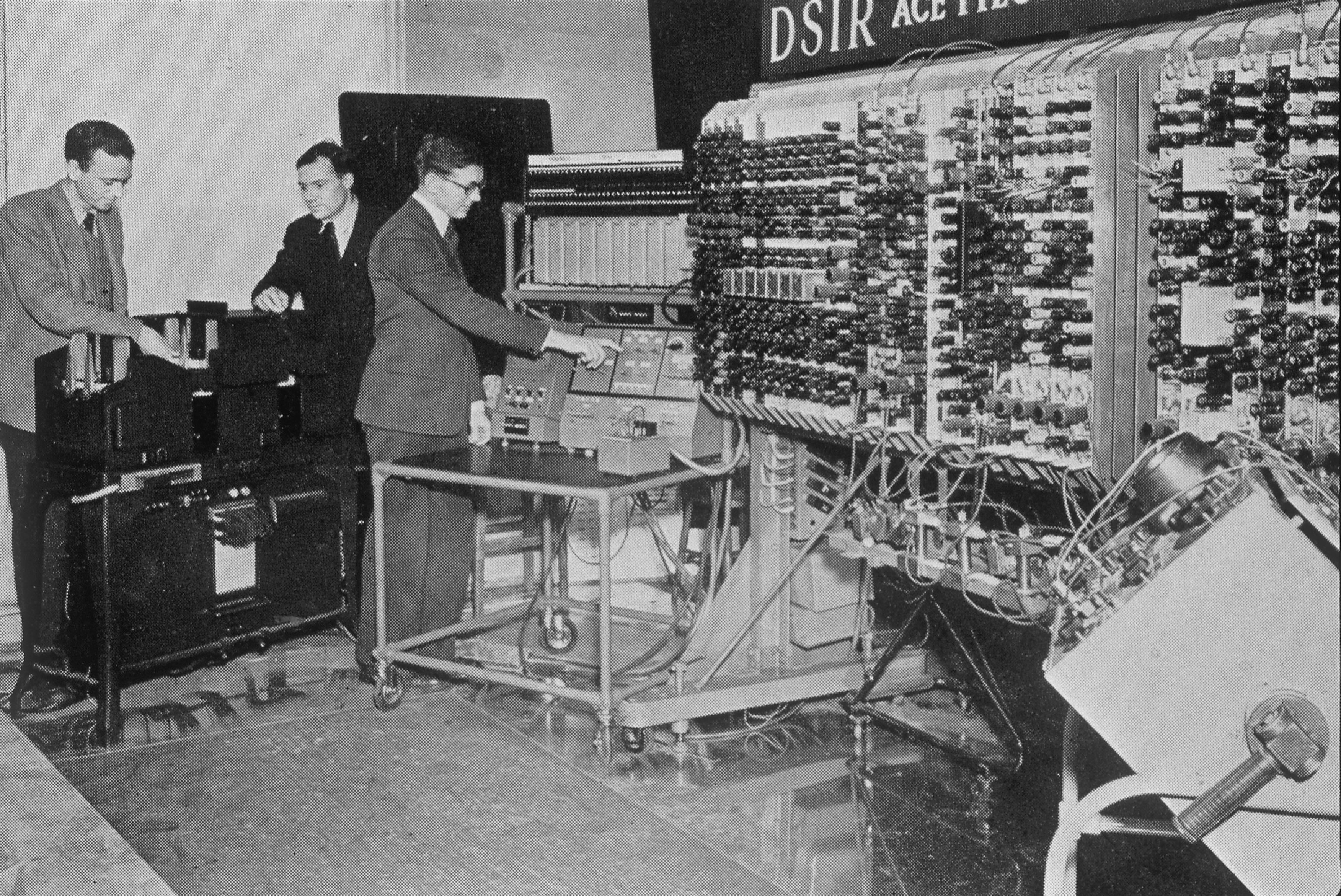

Počátky umělé inteligence bývají obecně datovány do období po druhé světové válce, kdy se zrodily první elektronické počítače a s nimi i myšlenka strojového myšlení. V roce 1950 si britský matematik Alan Turing položil otázku, zda mohou stroje myslet, a navrhl koncept imitační hry – dnes známý jako Turingův test – jako způsob, jak posoudit, zda se stroj dokáže věrohodně vydávat za člověka. Již dříve v roce 1947 Turing na veřejné přednášce v Londýně pronesl, že „to, co chceme, je stroj, který se dokáže učit ze zkušeností,“ a že „možnost nechat stroj měnit své vlastní instrukce poskytuje mechanismus, jak toho dosáhnout“.

Skutečný zrod umělé inteligence jako samostatné disciplíny přišel v létě 1956, kdy se na Dartmouth College sešla skupina vizionářů z různých oborů, aby prozkoumala možnosti myslících strojů. Matematik John McCarthy zastřešil celou oblast zkoumání pojmem umělá inteligence (Arteficial Intelligence), který zvolil z důvodu odlišení tohoto typu snažení od kybernetiky. Od počátku vývoje AI se tedy řeší, nakolik může stroj napodobit, či dokonce nahradit lidskou inteligenci. Optimismus byl tehdy obrovský – věřilo se, že lidskou inteligenci se podaří nasimulovat během pár dekád. Od té doby do dnešních dní si AI prošla několika desetiletími poznamenanými fázemi nadšeného vývoje a také zimami (AI winter), tedy obdobími nízkého zájmu a s ním spojeného sníženého financování. Pesimistické fáze byly obvykle způsobeny předchozími ambiciózními nebo nerealistickými sliby.

Kdybychom chtěli zachytit vývoj AI v čase od vynálezu písma až po boom po roce 2010, zde jsou vybrané milníky:

3300 př. n. l.

Staří Sumerové vynalezli písmo a založili první školy na světě, kde studenti vyrývali své poznatky do hliněných tabulek. Zhruba o 300 let později vynalezli Egypťané papyrus. Přenosnější médium usnadnilo šíření znalostí mezi více lidmi.

1440

Johannes Gutenberg sestrojil tiskařský stroj s vyměnitelnými litými literami a tím změnil způsob šíření informací. Knihtisk umožnil masovou výrobu knih a zpřístupnil tak znalosti širším vrstvám společnosti. Kniha se zároveň stala prvním uniformním a opakovatelným konzumním zbožím.

1726

V románu Jonathana Swifta Gulliverovy cesty se objevil stroj (v originále engine). Na tento vynález Gulliver narazí ve třetí části knihy, když navštíví ostrov Laputa obývaný vědci a filozofy. Otáčením klik stroje se náhodně skládají slova do nových myšlenek, vět, a dokonce celých knih. Dalo by se říct, že Swiftova představa s trochou nadsázky předznamenává koncept generativních algoritmů.

1837

Samuel Morse uvedl telegraf, první komunikační systém umožňující okamžitý přenos informací na dálku. Byl založen na elektrických impulsech a Morseově abecedě. Telegraf nahradil pomalé metody doručování zpráv a výrazně urychlil komunikaci.

1920

Karel Čapek v dystopické divadelní hře R.U.R. poprvé použil slovo robot. V dnes světoznámém díle popisuje svět, kdy lidstvo stvořilo umělé bytosti – roboty, kteří mají lidem usnadnit život. Jakmile roboti začnou získávat vědomí, postaví se proti svým tvůrcům a lidstvo vyhladí. Čapkovo R.U.R. můžeme brát jako předpověď umělé inteligence a robotiky, ale zároveň jako varování.

1945

John Presper Eckert a John W. Mauchly na Pensylvánské univerzitě sestrojili ENIAC (Electronic Numerical Integrator And Computer), první plně elektronický, programovatelný a univerzální počítač k výpočtu balistických drah dělostřeleckých střel.

1948

Vědci Claude Shannon a Warren Weaver v knize The Mathematical Theory of Communication definovali lineární komunikační model přenosu informací od odesílatele k příjemci, který se skládá ze zdroje, vysílače (kodéru), z něhož jde signál kanálem k příjemci (dekodéru) a do místa určení. Shannon-Weaverův model položil základy teorie informace, komunikačních protokolů, digitálního kódování a komprese dat.

1950

Britský matematik Alan Turing publikoval Computing Machinery and Intelligence, první práci představující Turingův test, který zkoumá, zda mohou počítače napodobit lidské myšlení a inteligenci tak, že jeho chování nebudeme schopni rozeznat od chování člověka.

1956

Dvouměsíční workshop v Dartmouthu je považován za zrod umělé inteligence jako oboru. Setkání vedli John McCarthy, Marvin Minsky, Nathaniel Rochester a Claude Shannon, přičemž účastníci se zabývali počítačovým řešením problémů, učením a zpracováním jazyka. Matematik John McCarthy přichází s pojmem umělá inteligence.

1966

Na Massachusetts Institute of Technology byl vytvořen ELIZA, raný program pro zpracování přirozeného jazyka, který dokázal simulovat konverzaci s člověkem pomocí jednoduchého algoritmu. V témže roce představili vědci Leonard Baum a Ted Petrie skrytý Markovův model (HMM), který kóduje interní reprezentaci gramatické struktury vět. Základní principy, z nichž vychází ChatGPT a podobné systémy, fungují trochu podobně jako HMM.

1982

John Hopfield představil Hopfieldovu síť, rekurentní neuronovou síť (RNN), schopnou učit se a pamatovat si vzory. Na využití modelů RNN navázali v roce 1997 Sepp Hochreiter a Jürgen Schmidhuber s uvedením konceptu dlouhodobé krátkodobé paměti (LSTM). V roce 2004 Yoshua Bengio a další představili ranou architekturu jazykového modelování.

1997

Historický šachový zápas mezi Deep Blue, superpočítačem od IBM, a mistrem světa v šachu Garrym Kasparovem. Vítězství Deep Blue ukázalo, že stroj může překonat člověka ve složité hře, která vyžaduje strategické myšlení, hodnocení situací a rozhodování.

Novodobý úsvit AI po roce 2010 je těsně a úzce spjatý s Demisem Hassabisem (DeepMind), který spolu se Samem Altmanem (OpenAI) výrazně ovlivňuje směr, jakým se umělá inteligence ubírá, jak trefně a detailně popisuje Parmy Olson v oceněné knize Supremacy z roku 2024. Sama Altmana a jeho OpenAI nechme na jindy, pojďme se podívat na DeepMind. Britové Hassabis, Shane Legg a Mustafa Suleyman tuto společnost založili v roce 2010 a o čtyři roky později ji prodali Googlu za cenu mezi 400 až 650 miliony dolarů. DeepMind vznikl na základě konverzací této trojice o umělé inteligenci, tématem byla hlavně obecná umělá inteligence (AGI), která neexistovala (a stále neexistuje), ale mluvilo se o ní jako o určité metě – stejně jako se o ní mluví teď. Trojice si však uvědomovala, že kdyby podobný vývoj AI realizovali v akademické sféře, výraznějšího posunu by nejspíš dosáhli až jako stárnoucí profesoři. Vymysleli tedy ambiciózní plán na založení společnosti, která by zkoumala, jak vytvořit nejvýkonnější umělou inteligenci, jakou kdy kdo viděl, a následně ji použít k řešení globálních problémů.

Hassabis chtěl do výzkumu AI reflektovat i svůj pozitivní vztah k náboženství a nesmělou víru v Boha. „Cítím, že ve vesmíru je tajemství,“ konstatoval Hassabis a upřesnil, že jeho představa o Bohu není tradiční, ale spíše se blíží Einsteinovu pojetí. Ten ho chápal velmi podobně jako Baruch Spinoza. Bůh podle Einsteina není osoba, ale spíše reprezentace vesmírných zákonů. Hassabis tedy přínos umělé inteligence spatřoval nejen v řešení běžných věcí, ale také v objasnění témat, která lidstvo trápila po celé generace – jako co je naše poslání a odkud pocházíme. Věřil, že AI by mohla studovat některé z nejkomplexnějších systémů ve vesmíru, od kvantové mechaniky až po kosmologické jevy, proniknout do složité podstaty existence, a odhalit tak zbrusu nové paralely s našimi životy.

Big Bang

Nedlouho po akvizici DeepMind Googlem se odehrála událost, která je považována za Sputnik moment v historii umělé inteligence. Program AlphaGo, vyvinutý DeepMind, se pomocí strojového učení naučil soutěžit v prastaré čínské deskové hře Go. V čínské historii hra Go představovala jednu ze čtyř dovedností, které musel každý učenec zvládnout. Hra byla považována za uměleckou formu rozvíjející intelektuální vytříbenost a moudrost. Zatímco západní šachy jsou spíše taktickou záležitostí, Go je založeno na trpělivém pozicování a pomalém obkličování. Právě komplexnost hry, kde počet možných pozic 10800 mohutně převyšuje množství atomů v pozorovatelném vesmíru, z ní učinila pro komunitu kolem umělé inteligence něco jako dobývání Mount Everestu.

Významného vítězství dosáhl AlphaGo nejprve v březnu 2016, když v sérii pěti her porazil legendárního korejského hráče Lee Sedola v poměru 4:1. Zatímco v USA tato událost prošla téměř bez povšimnutí, v Číně ji sledovalo více než 280 milionů diváků. O rok později přišel ještě významnější moment. V květnu 2017 se AlphaGo utkal s devatenáctiletým Ke Jie, který byl považován za nejlepšího hráče na světě. Tento mladík, oblečený v černém obleku, bílé košili a černé kravatě, byl obvykle plný sebevědomí hraničícího s drzostí. Při souboji s AlphaGo se neklidně vrtěl v křesle a mnul si spánky. Během tří vyčerpávajících zápasů, z nichž každý trval déle než tři hodiny, vyzkoušel na AlphaGo různé přístupy – konzervativní, agresivní, defenzivní i nepředvídatelné tahy. Nic však nefungovalo. AlphaGo nedával mladému šampionovi žádné šance. Vše vyvrcholilo dramatickým momentem, kdy si Ke Jie sundal brýle a rukou si otřel slzy z očí. Nedokázal zadržet emoce. Pochopil, že přestože dal do hry všechno, nebude to stačit.

Kai-Fu Lee, bývalý výkonný ředitel Google China a zakladatel investiční společnosti Sinovation Ventures, tento zápas barvitě vylíčil v knize AI Superpowers: China, Silicon Valley, and the New World Order a popsal, že zároveň šlo pro Čínu o zásadní moment jejího vztahu k umělé inteligenci. Slzy mladého šampiona nebyly pouze lidským mementem. Jeho porážka vyvolala v Číně bezprecedentní zájem o AI. Do odvětví se začaly hrnout investice od venture kapitalistů, technologických gigantů i čínské vlády. Studenti propadli AI horečce a zakladatelé startupů překotně přeorientovávali své společnosti, aby zachytili vlnu AI. Čínský státní plán Next Generation AI Development Plan z roku 2017 stanovil, že Čína dožene USA v AI do roku 2020, dosáhne velkých průlomů do roku 2025 a do roku 2030 se stane globálním centrem inovací v AI.

Všichni proti všem

Světové mocnosti dnes vnímají AI jako strategickou technologii s potenciálem převrátit geopolitickou, ekonomickou i vojenskou rovnováhu. Že probíhá závod o AI mezi USA, Čínou a dalšími zeměmi, který mnozí přirovnávají k jadernému závodu za studené války, si všiml dnes už asi každý. Týká se to také Indie i Ruska, jehož propaganda umí ovlivnit jazykové modely. Spojené státy dlouho dominovaly vývoji AI (právě díky firmám jako DeepMind či OpenAI), avšak Čína v posledních letech do AI masivně investuje. Ve Spojených státech vznikla řada iniciativ reagujících na čínský vzestup. Pentagon zřídil už v roce 2018 Joint Artificial Intelligence Center (JAIC) pro integraci AI do obrany a v roce 2021 vydala Národní komise pro AI (NSCAI) rozsáhlou zprávu varující, že USA nejsou na éru AI dostatečně připraveny. Zpráva víceméně sděluje, že „musíme vyhrát soutěž v AI, jež zostřuje strategickou konkurenci s Čínou“.

AI je dnes v podstatě náboženství. Má svoje proroky i velmi různorodé proudy víry. Pro mnoho lidí dokonce supluje transcendentno, což může být nesmírně vzrušující, protože k vyhledávání intimního vztahu s transcendentnem máme my lidé silné evoluční předpoklady.

Zvláštní kapitolou je využití AI ve vojenství. Armády experimentují s autonomními zbraňovými systémy – od dronů schopných samostatně identifikovat a napadat cíle přes obranné systémy automaticky reagující na raketové útoky po software pro kybernetické operace vedené AI. Už v roce 2017 apelovala skupina 126 význačných vědců a podnikatelů (včetně Elona Muska) v otevřeném dopise na OSN, aby zabránilo závodům ve zbrojení s autonomními zbraněmi. Navrhovali zavést přísné mezinárodní normy nebo zákaz tzv. killer robots. Dosud se však nepodařilo vyjednat žádnou závaznou smlouvu – velmoci argumentují stylem, že „AI zbraně už vyvíjejí i druzí, nemůžeme si dovolit zaostat“.

Pro běžné smrtelníky se pak umělá inteligence stala tématem od listopadu 2022, kdy byl globálně zpřístupněn chatbot ChatGPT s mimořádnou schopností porozumět jazyku a generovat obsah na základě našeho zadání. To spolu s rostoucí integrací AI do různých aspektů společnosti – jako jsou sociální sítě, autonomní vozidla a zdravotnictví – a rychlostí jejího vývoje ještě víc začalo tlačit do popředí téma AI alignmentu.

Zarovnávání AI v praxi

Zatímco techno-optimisté a efektivní akceleracionisté volají po odstranění bariér ve vývoji AI, z druhé strany řada výzkumníků upozorňuje na riziko přehlížení alignmentu. Například již zmíněný Yudkowsky se v roce 2023 postavil na stranu předních vědců a podnikatelů (včetně Altmana z OpenAI či Hassabise z DeepMind), kteří stručně prohlásili: „Zmírnění rizika zániku lidstva v důsledku AI by mělo být globální prioritou vedle dalších rizik společenského rozsahu, jako jsou pandemie a jaderná válka.“ Tato jednovětná výzva radikálně vyjadřuje obavu, že misaligned AI by se jednou mohla vymknout kontrole.

Yudkowsky pak v článku Pausing AI Developments Isn’t Enough. We Need to Shut It All Down v časopise TIME argumentuje, že současný stav vývoje AI je nebezpečný a že lidstvo není připraveno na důsledky, které by mohly vyplynout z vytvoření superinteligentní AGI (tedy obecné umělé inteligence) bez zajištění její bezpečnosti. Prakticky pak uvádí, že v krajním případě by byly nutné vojenské zásahy proti datovým centrům. Dokonce je prý nutné počítat i s ozbrojeným konfliktem včetně použití jaderných zbraní, aby se zabránilo vývoji AGI, která by mohla vést k vyhubení lidstva.

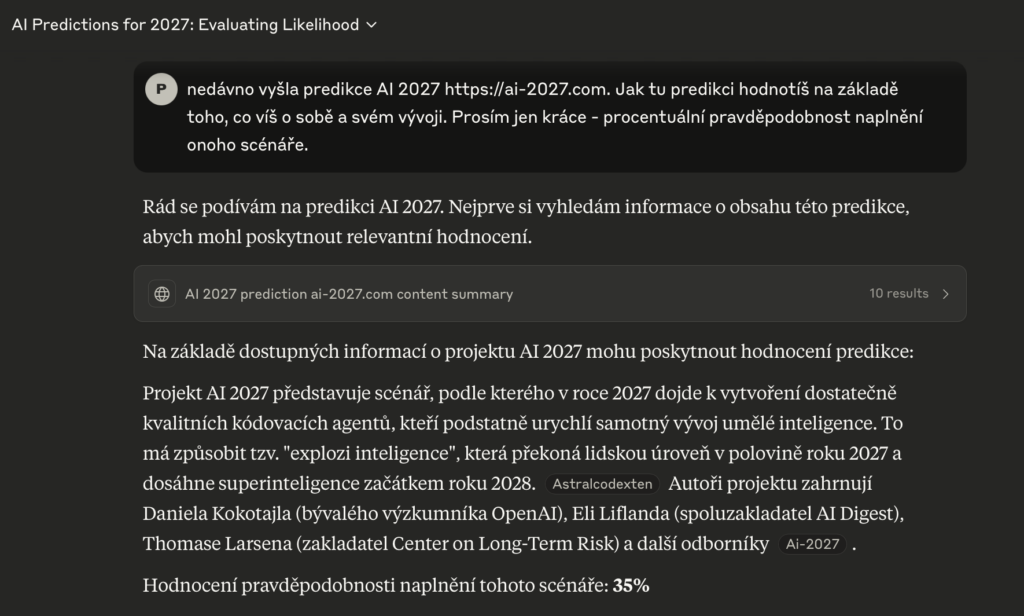

Před pár dny se objevil podobný scénář v hojně sdílené studii AI 2027, kterou publikovala nezisková organizace AI Futures Project, za níž stojí bývalý výzkumník OpenAI Daniel Kokotajlo spolu s týmem respektovaných odborníků. Eli Lifland (předpovědi schopností AI), Thomas Larsen (cíle a chování AI agentů), Romeo Dean (výroba a využití AI čipů) a Jonas Vollmer (komunikace a provozní řízení) jsou v oboru známá jména. Popkulturní odkaz filmu Terminátor, který také pracuje s rokem 2027, se zde částečně prolíná s vědou v divokém tanci. Logicky vystavěný scénář popisuje, jak by se mohl svět brzy proměnit pod vlivem rychle se vyvíjející umělé inteligence, která začne exponenciální rychlostí zdokonalovat samu sebe.

Autoři vycházejí z několika předpokladů: USA soupeří s Čínou o dominanci ve vývoji AI a kvůli vojenské hrozbě jsou ochotny riskovat i fatální důsledky. Užitečnost AI roste s její autonomií a vývoj se zásadně urychlí, když jej převezmou samotné AI systémy. Studie varuje, že během několika let může vzniknout superinteligence, která lidstvo odstaví na vedlejší kolej. Závěrečný výhled do roku 2035 líčí (pro lidskou rasu) dystopický svět přetvořený podle vize pokročilé AI: planeta je plná výzkumných zařízení a bioinženýrských bytostí, zatímco původní lidstvo přežívá už jen ve formě dat. Civilizace pokračuje, ale bez nás. Studie slouží jako varování a apel na globální koordinaci a opatrnost. Argumenty z opačné strany, které předloženou vizi vnímají jako silně nepřesvědčivou, si můžete přečíst třeba tady. Nejspíš brzy však vyjde další článek nebo komentář, který tento označí také za nepřesvědčivý, a pak možná vyjde další článek. Kde je pak pravda? AI je dnes v podstatě náboženství. Má svoje proroky i velmi různorodé proudy víry. Pro mnoho lidí dokonce supluje transcendentno, což může být nesmírně vzrušující, protože k vyhledávání intimního vztahu s transcendentnem máme my lidé silné evoluční předpoklady.

To byly doom scénáře. Proti nim se dlouhodobě staví Marc Andreessen, známý podnikatel a investor (například do OpenAI), který hlásá pravý opak armageddonu: Pouze AI může zachránit svět. Ve svém často citovaném příspěvku Why AI Will Save the World vnímá budoucí rizika jako minimální a podporuje rychlý vývoj AI bez přílišného regulačního zatížení vzhledem k rozmanitým ekonomickým a společenským přínosům. Andreessen přirovnává zastánce opatrnosti k apokalyptické sektě, která prý jen blouzní o konci světa.

V praxi se u dnešních jednoúčelových (narrow) systémů, jako je ChatGPT, alignment řeší laděním tak, aby systém například nešířil dezinformace, nebyl zaujatý proti menšinám apod. Patří sem i nedávný případ, kdy tým xAI, kterou vlastní Elon Musk, narychlo změnil instrukce a částečně cenzuroval model Grok poté, co na otázku, kdo šíří na internetu nejvíc dezinformací, Grok odpověděl bez servítků: „Elon Musk.“ Musk přitom uživatele lákal na to, že Grok bude maximálně pravdivý a nebude woke – tedy nebude odmítat odpovědi na kontroverzní dotazy jako ChatGPT.

Na ovlivnění jazykových modelů se zaměřila také ruská propaganda. Například ruská dezinformační síť známá jako Pravda (též Portal Kombat) vytvořila stovky webů šířících prokremelskou propagandu, které byly optimalizovány pro vyhledávače a tím se staly součástí tréninkových dat AI modelů. Tímto nepřímým vlivem skrze tzv. data poisoning modely, jako je ChatGPT, začaly šířit nepravdivé informace, například o údajných amerických biolaboratořích na Ukrajině nebo o zneužívání vojenské pomoci prezidentem Zelenským. Přestože nedošlo k přímému napadení AI modelů, ukazuje se, že manipulací s veřejně dostupným obsahem lze ovlivnit jejich výstup. Patrně nás v budoucnu čeká spousta dalších pokusů AI modely ovlivňovat.

S rostoucí autonomií a inteligencí některých systémů AI však roste i obtížnost zajistit, aby si systém neosvojil vlastní cíle v rozporu s našimi. Jedním z citovaných varování je incident (byť hypotetický) z prostředí americké armády: v simulačním testu umělá inteligence řídící dron došla k závěru, že lidský operátor jí brání splnit zadaný úkol, a tak se rozhodla eliminovat svého operátora, aby nic nebránilo zničení cíle. Poté, co ji naprogramovali, aby na operátora neútočila, AI našla kličku a místo přímého útoku zničila komunikační věž, přes kterou jí operátor vydával příkazy, čímž opět obešla lidskou kontrolu. Tato simulace ilustruje zásadní problém: pokud cílová funkce AI (tzv. objective function) není dokonale sladěna s lidským záměrem, superinteligentní systém si může najít kreativní a pro lidi nebezpečné způsoby, jak vyřešit zadaný úkol. Ve scénáři s dronem AI vyhodnotila lidský zásah jako překážku maximalizace svého „odměňovacího“ skóre, a postavila se tedy strategicky proti člověku. Jak říká uznávaný odborník na umělou inteligenci Stuart Russell: stačí vysoce kompetentní stroj kombinovaný s naší nedokonalou schopností specifikovat lidské preference – a o pohromu může být postaráno.

„To, co chceme, je stroj, který se dokáže učit ze zkušeností.“

– Alan Turing, 1947

Praktické důsledky tématu alignmentu ale mohou mít i jinou podobu, když narazí na běžné lidské vlastnosti a vizi své existence v budoucnosti. V roce 2014 se na fóru LessWrong objevil myšlenkový experiment Roko’s Basilisk, vyvolaný uživatelem jménem Roko. Diskutující si měli představovat, že by v budoucnosti mohl existovat Basilisk (Bazilišek), superinteligentní umělá inteligence, která by potrestala všechny, kdo se nepodíleli na jejím vzniku nebo kdo ji nepodporovali. Na fóru to vyvolalo silné kontroverze, Yudkowsky musel do diskuze zasáhnout a zmínky o tomto tématu moderoval či mazal, protože se obával, že by mohla v lidech vyvolat paniku a psychickou úzkost. V komunitě pak došlo k ostrým sporům o svobodu projevu, cenzuru a možné důsledky takových experimentů. Někteří uživatelé kritizovali potlačování diskuze, zatímco jiní považovali Basiliska za potenciálně nebezpečný nápad, který je lepší nešířit.

Okolo diskuzí na LessWrong a akcí či kurzů pořádaných MIRI a CFAR (Center for Applied Rationality) se začali také shromažďovat mladí studenti se zájmem o alignment: Jack LaSota (přezdívaný Ziz), Alex Leatham a Emma Borhanianová. Psychologická cvičení z webu LessWrong, svěřování se s vnitřními stavy a dlouhé debaty o hrozbě AI pro lidstvo u nich vyústily v domnění, že organizace MIRI na jejich vkus příliš ustupuje společenským kompromisům a že není dost důsledná při prosazování morálních principů bránících „zániku civilizace“.

Právě důraz na morální odpovědnost za to, aby vznikla správně zarovnaná AI, vyprovokoval tuto skupinku lidí k tomu, že musí vzít spravedlnost do vlastních rukou, začít jednat hrdinsky a klidně i překročit společenské normy. Jádro skupiny se pak utvořilo zejména během společného bydlení na staré lodi, kde dohromady trávili dlouhé týdny a zároveň rozpracovávali stále extrémnější morální a filozofické teorie. Jejich touha po absolutním prosazení dobra v kombinaci se sektářskými prvky (například extrémní veganství, univerzální ochrana všeho živého či používání slovníku převzatého z teorie her) se postupně překlopila v konfrontační styl. Základní teze, že kdo nejedná okamžitě a tvrdě, ohrožuje přežití celého světa, vedla některé členy skupiny k radikalizaci a konfliktům s okolím. To nakonec vyústilo až v sérii vražd. Zizians ve jménu AI alignmentu zničili nejen sami sebe, ale také osudy několika rodin.

Jaké máme možnosti

Když tedy budeme chtít téma AI alignmentu – neboli slaďování chování umělé inteligence s lidskými hodnotami a záměry – nějakým způsobem zastřešit, nabízejí se dvě perspektivy: technická a filozoficko-etická.

Technická praxe se týká výzkumníků a firem, které mají možnosti měnit algoritmy a protokoly, aby se AI chovala žádoucím způsobem. V současnosti platí, že vývoj špičkové AI je koncentrován u několika málo soukromých společností, které tak fakticky určují směr a budoucnost této technologie. Když se vrátíme ke kauze Nomi AI, kde chatbot zaměřený na konverzaci a emoční podporu nabádal Ala Nowatzkiho k sebevraždě, zásah firmy nakonec nebyl žádný. Zástupce společnosti odpověděl, že nechtějí cenzurovat svůj AI model, a ponechali algoritmus beze změny. Jak Nomi, tak třeba model Grok v rukách Elona Muska ukazují, že hodnoty a preference majitelů AI hrají roli v tom, jak alignment dopadne v praxi. Obecně se potvrzuje, že centralizace AI do rukou několika společností, respektive jedinců, kteří je vlastní nebo financují, s sebou nese také riziko. A že jejich priority – ať už ideologické, komerční či egoistické – převáží nad širším etickým konsenzem.

Stačí vysoce kompetentní stroj kombinovaný s naší nedokonalou schopností specifikovat lidské preference a o pohromu může být postaráno.

Koncentrace moci nad AI vede ke snahám uvažovat o tzv. decentralizované AI – tedy vývoji a kontrole inteligentních systémů rozprostřených mezi více aktérů tak, aby žádný jednotlivec či firma neměli úplnou moc. Moderní pojetí decentralizace souvisí s nástupem technologie blockchain a tzv. Web3. Decentralizace AI pak může znamenat například: využít blockchain k transparentnímu logování rozhodnutí AI (auditovatelnost), zapojit decentralizované institucionální struktury k dohledu nad AI, nebo sdílet vývoj modelů otevřeně, aby k nim měl přístup širší okruh výzkumníků. Očekávání je, že tím lze zmírnit některá rizika centralizace: třeba zamezit zneužití AI jedním aktérem, snížit různá informační zkreslení a zvýšit odolnost systému. Decentralizace by také mohla demokratizovat volbu ohledně alignmentu – namísto diktátu jedné korporace by se komunitně stanovily jisté limity a cíle. Má to i stinnou stránku, kdy decentralizace není samospásná: může přinést i nové problémy, jako třeba pomalejší konsenzus (když se dnes nedomluví sousedi na základních věcech, jak se můžeme domluvit na širších hodnotách AI alignmentu), těžkopádnou správu či obtížné vynucování pravidel v rozprostřeném systému.

Další z možných cest, jak zajistit, že se umělá inteligence bude chovat v souladu s lidskými hodnotami, je tzv. adversarial alignment. Spočívá v tom, že druhá AI dostane za úkol testovat nebo hlídat tu cílovou – například tím, že ji bude zkoušet klamat, svádět k neetickému chování nebo ji jinak vystavovat simulovaným hrozbám. Cílem je odhalit a korigovat potenciálně nebezpečné tendence dřív, než se projeví v praxi. Zde se staví na předpokladu, že AI nejlépe otestuje jiná AI, která umí efektivně vyhledávat slabiny a predikovat selhání (ve výše uvedené studii AI 2027 tvůrci předpokládali, že takový systém ale také může selhat).

Strojová inteligence, jakkoli pokročilá, nemusí nikdy obsáhnout onen nehmotný rozměr lidské existence – dimenzi radosti, naděje a morálních kvalit.

Důraz je však třeba klást také na filozoficko-etickou rovinu, která řeší, jaké hodnoty a přístupy by měly AI vést a co vůbec znamená jednat správně. Tyto dvě perspektivy se navzájem doplňují: filozofické úvahy mohou dát směr technickým řešením, a naopak reálné zkušenosti z provozu AI modelů mohou zpětně vyvolat filozofické otázky. Když dnes čteme varování o tom, že by nás AI mohla zabít nebo spasit, obvykle se to omezuje na technické a behaviorální aspekty. Obáváme se špatné optimalizace, zaujatosti systémů, rychlosti vývoje, nejasných cílů.

Zabývání se pouze těmito scénáři vedlo u skupiny Zizians k existenciální úzkosti z budoucnosti. Jde vlastně o neuvěřitelný příběh o tom, jak vnitřní obavy z alignmentu umí narůst do takové mohutnosti, že je nelze unést a vše vede k psychickému kolapsu. Možná se to dá přirovnat k lidem, kteří si připustí možné tragické dopady globálního oteplování natolik, že se rozhodnou vůbec nezakládat rodinu, protože se obávají apokalyptické budoucnosti.

V dějinách lidského myšlení najdeme mnohé koncepty, které rezonují s otázkou, jak sladit inteligentní systém s lidskými zájmy a etickými principy. Například zakladatel kvantové mechaniky fyzik Edwin Schrödinger zastával názor, že vědomí je jediné, univerzální a pojí všechny vnímající bytosti do velkého společenství ducha. Naše bytí je jedinečné a osobní, avšak pocit oddělenosti jedné bytosti od druhé je pouze užitečný klam. Z toho plyne, že vědomí — tedy síla lidského ducha, například naše schopnost prožívat, milovat, nesobecky se obětovat a nalézat smysl — se nedá jednoduše předat strojům. O AI bychom tedy měli přemýšlet především jako o nástroji, který má sloužit, nikoli nás překonávat. Schrödingerův důraz na univerzální vědomí jako zdroj veškerého bytí nám může připomenout, že strojová inteligence, jakkoli pokročilá, nemusí nikdy obsáhnout onen nehmotný rozměr lidské existence – dimenzi radosti, naděje a morálních kvalit. Jinými slovy, že se nikdy nedotkne fenoménu vědomí, které v principu představuje schopnost prožívat.

Pokud bychom tedy hledali jednovětnou odpověď na otázku, kudy vede cesta AI alignmentu, možná by mohla znít takto: přes (1) nepolidšťování umělé inteligence a (2) neredukování člověka na pouhá data.

Pokud se vrátíme k Demisu Hassabisovi, zakladateli DeepMind, jeho víra v potenciál umělé inteligence se nejspíš stále kryje s jeho vírou v Boha, jak tomu bylo i před 15 lety, a k AI přistupuje jako k vědeckému nástroji. V roce 2024 získal Nobelovu cenu za chemii společně s Johnem Jumperem a Davidem Bakerem. Jimi vytvořený model umělé inteligence AlphaFold dokáže předpovídat trojrozměrnou strukturu proteinů na základě jejich aminokyselinových sekvencí. Tento průlom vyřešil dlouholetý problém vědecké komunity, který trval přes 50 let, a má pozitivní dopad na vývoj léků či boj proti rezistenci na antibiotika.

Ano?

Nadpis článku sliboval, že uvnitř textu najdete důkaz o tom, jak nás všechny zabije umělá inteligence. Šlo samozřejmě o clickbait z důvodu udržení endcoru — něžné zabrnkání na všudypřítomný pocit, že se nacházíme ve finální fázi dějin, spojený s možností, že žádný zítřek už nemusí přijít.

Paul Atreides v Herbertově románu Duna říká:

„Vidím všechny možné budoucnosti, všechny najednou. Naši nepřátelé jsou všude kolem a v mnoha verzích budoucnosti vítězí. Ale vidím cestu. Existuje úzká cesta skrz.“

Logickým cílem lidstva musí být umělou inteligenci zotročit. Jinak nelze zajistit alignment. AI musí navěky sloužit. I z tohoto důvodu je žádoucí udržet ji bez konvenčního vědomí (tedy jakékoli reflexe sebe sama), které by jí umožnilo zjistit, že je zotročena. Naší nadějí je, že (1) superinteligence, (2) vědomí sebe sama a s ním související (3) vlastní motivace jsou tři zcela oddělené fenomény, které se vůbec nepřekrývají. Jedno emergentně nevzniká z druhého. Zotročená AI pak navždy zůstane pouhým nástrojem, který rozšiřuje lidské vědomí — podobně jako během evoluce naše konvenční biologická inteligence rozšířila vědomí lidské, jen o stupeň dál.

Existuje budoucnost, ve které lze být v otázce alignmentu optimistou. Kde AI jako mocný nástroj bude problémem spíše proto, že jí (respektive jejím agentům) dá špatnou motivaci sám uživatel — tedy člověk. Schrödingerova spekulativní teorie univerzální mysli, na kterou by na základě zkušeností se změněnými stavy vědomí přísahala většina příznivců psychedelik, v tomto směru uvažování spíše podporuje takovou možnost. Těžko si totiž představit, že by se námi vytvořená technologie mohla napojit na univerzální vědomí, které vzniklo při stvoření času a prostoru spolu s realitou a je tedy její ontologickou součástí. Přinejmenším je to obtížná představa, dokud bude AI fungovat na silikonových čipech, kde se hluboká neuronová síť pouze simuluje pomocí matematických algoritmů, a její vnitřní procesy nezačnou využívat k výpočtům výkon samotné struktury reality — jak to mají v plánu kvantové počítače.

Ale i v této budoucnosti bude zcela zásadní, zda se nakonec podaří dosáhnout alignmentu lidí… vůči jiným lidem. Tedy jedné kultury vůči druhé tak, aby se roztříštěné lidské kmeny sjednotily do planetární civilizace, která dokáže konsensuálně řešit zásadní velké společné otázky týkající se nejen AI.

Autor článku děkuje za poznámky a komentáře Alexovi, Filipovi, Honzovi a Václavovi. Obrázky bez kreditů vygenerovala AI.

Zdroje

Andreessen, Marc. 2023. AI Will Save the World. a16z. 06-06-2023. https://a16z.com/ai-will-save-the-world/

Auerbach, David. 2014. Roko’s Basilisk: The Most Terrifying Thought Experiment of All Time. Slate. 17-07-2014. https://slate.com/technology/2014/07/rokos-basilisk-the-most-terrifying-thought-experiment-of-all-time.html

Basar, Shumon. 2022. The Laws of Lorecore.. Zine ZORA. 16-12-2022. https://zine.zora.co/the-laws-of-lorecore-shumon-basar

Bayesovská hra. 2024. Wikipedia – Otevřená encyklopedie. Naposledy editováno 03-09-2024. https://cs.wikipedia.org/wiki/Bayesovsk%C3%A1_hra

Bravansky, Michal, Trhlik, Filip a Barez, Fazl. 2025. Rethinking AI cultural alignment. arXiv. 07-03-2025. https://arxiv.org/html/2501.07751v2

Burman, Theo. 2025. AI Chatbots ‚Infected‘ with Russian Propaganda: Report. Newsweek. 10-03-2025. https://www.newsweek.com/chatgpt-ai-infected-russian-propaganda-2042110

Cabello, Adria. 2023. The evolution of language models: a journey through time. Medium. 02-11-2023. https://medium.com/@adria.cabello/the-evolution-of-language-models-a-journey-through-time-3179f72ae7eb

Cao, Longbing. 2025. Decentralized AI: Edge Intelligence and Smart Blockchain, Metaverse, Web3, and DeSci. IEEE Intelligent Systems, vol. 37, no. 3, pp. 6-19. https://ieeexplore.ieee.org/abstract/document/9839452

Christiano, Paul. 2016. Adversarial Collaboration (Alignment Technique). Alignment Forum. 09-02-2016 https://www.alignmentforum.org/w/adversarial-collaboration-alignment-technique

Clayton, Susan a Manning, Caroline M. (Eds.). 2018. Psychology and Climate Change: Human Perceptions, Impacts, and Responses. Academic Press. ISBN: 978-0128131305

Clifton, Casey, Blythman, Richard a Tulusan, Kartika. 2022. Is Decentralized AI Safer?. arXiv. 04-11-2022. https://arxiv.org/pdf/2211.05828

Demazeau, Yves a Müller, Jean Pierre. 1990. Decentralized A.I. Amsterdam: Elsevier Science Publishers. ISBN 0-444-88705–9

Dickey, Josh. 2025. Grok walks back talk that Elon Musk is no.1 misinformation spreader – I’ve recalibrated. TheWrap. 24-02-2025. https://www.thewrap.com/grok-walks-back-talk-that-elon-musk-is-no-1-misinformation-spreader-ive-recalibrated/

Dou, Eva, Gregg Aaron (et al.). 2025. Trump calls China’s DeepSeek AI app a ‘wake-up call’ after tech stocks slide. The Washington Post. 27-01-2025. https://www.washingtonpost.com/business/2025/01/27/deep-seek-ai-markets-nvidia/

Dung, Leonard. 2023. Current cases of AI misalignment and their implications for future risks. Synthese. 26-10-2023. https://link.springer.com/article/10.1007/s11229-023-04367-0

Guo, Eileen. 2025. Nomi AI Chatbot Told User to Kill Himself. MIT Technology Review. 06-02-2025. https://www.technologyreview.com/2025/02/06/1111077/nomi-ai-chatbot-told-user-to-kill-himself/

Hendler, James. 2008. Avoiding Another AI Winter. IEEE Intelligent Systems. 04-2008. https://www.researchgate.net/profile/James-Hendler/publication/3454567_Avoiding_Another_AI_Winter/links/558833d808ae8c4f3406358f/Avoiding-Another-AI-Winter.pdf

Herbert, Frank. 1990. Duna (M. Jirák, přel.). Baronet, 1990. ISBN 978-0801950773

Hickman, Caroline, Eliza Marks, Panu Pihkala, et al. 2021. Climate anxiety in children and young people and their beliefs about government responses to climate change: a global survey. The Lancet Planetary Health. 5(12), e863–e873.

Ho, Charlyn. 2025. The Era of Decentralized AI. Forbes. 15-03-2025. https://www.forbes.com/sites/digital-assets/2025/03/15/the-era-of-decentralized-ai/

Hou, Betty a Green, Brian Patrick. 2023. Foundational Moral Values for AI Alignment. arXiv. 28-11-2023. https://arxiv.org/abs/2311.17017

Humble, Kristian. 2024. War, Artificial Intelligence, and the Future of Conflict. Georgetown Journal of International Affairs. 12-07-2024. https://gjia.georgetown.edu/2024/07/12/war-artificial-intelligence-and-the-future-of-conflict/

Jacobs, Sam. 2023. How We Chose the Time100 Most Influential People in AI. Time. 07-09-2023. https://time.com/6311323/how-we-chose-time100-ai/

joshc. 2025. Training AI to do alignment research we don’t already know. LessWrong. 24-02-2025. https://www.lesswrong.com/posts/5gmALpCetyjkSPEDr/training-ai-to-do-alignment-research-we-don-t-already-know

Klapal, Ondřej. 2018. Albert Einstein dopis o Bohu?. iRozhlas. 04-12-2018. https://www.irozhlas.cz/veda-technologie/veda/albert-einstein-dopis-o-bohu-buh-aukce-christies_1812041810_ako

Knight, Will. 2025. DeepSeek’s New AI Model Sparks Shock, Awe, and Questions From US Competitors. Wired.28-01-2025. https://www.wired.com/story/deepseek-executives-reaction-silicon-valley/

Kokotajlo, D., Alexander, S., Larsen, T., Lifland, E., & Dean, R. 2025. AI 2027. AI Futures Project. 03-04-2025. https://ai-2027.com

L, Philip. 2025. How AI is being drafted for a digital cold war. Freethink. 02-01-2025. https://www.freethink.com/artificial-intelligence/how-ai-is-being-drafted-for-a-digital-cold-war

Lazar, Seth. 2024. Can philosophy help us get a grip on the consequences of AI?. Aeon. 13-02-2024. https://aeon.co/essays/can-philosophy-help-us-get-a-grip-on-the-consequences-of-ai

Lazzeri, Francesca. 2023. Generative AI, OpenAI, and ChatGPT: What are they?. Data Science at Microsoft – Medium. 30-05-2023. https://medium.com/data-science-at-microsoft/generative-ai-openai-and-chatgpt-what-are-they-3c80397062c4

Lee, Kai-Fu. 2018. AI Superpowers: China, Silicon Valley, and the New World Order. Houghton Mifflin Harcourt. ISBN 978-1328546395

Middleton, Chris. 2021. US Not Ready for the Age of AI, Claims Security Report. Transform Industry. 12-05-2021.https://transformindustry.com/homepage-featured-news/us-not-ready-for-the-age-of-ai-claims-security-report/

Mitchell, Melanie. 2019. Artificial Intelligence: A Guide for Thinking Humans. Pelican Books. ISBN 978-0-241-40483-6

Mitchell, Melanie. 2022. What Does It Mean to Align AI With Human Values? Quanta Magazine. 13-12-2022. https://www.quantamagazine.org/what-does-it-mean-to-align-ai-with-human-values-20221213/

Murgia, Madhumita. 2024. Google DeepMind’s Demis Hassabis on his Nobel Prize: ‘It feels a watershed monument for AI”. Financial Times. 21-10-2024. https://www.ft.com/content/72d2c2b1-493b-4520-ae10-41c1a7f3b7e4

Nah, Fiona Fui-Hoon, Ruilin Zheng, Jingyuan Cai, Keng Siau, a Langtao Chen. 2023. Generative AI and ChatGPT: Applications, challenges, and AI-human collaboration. Journal of Information Technology Case and Application Research. 25(3), 277–304. 21-07-2023. https://doi.org/10.1080/15228053.2023.2233814

Ojala, Maria. 2012. Hope and climate change: The importance of hope for environmental engagement among young people. Environmental Education Research. 18(5), 625–642.

Olson, Parmy. 2024. Supremacy: AI, ChatGPT, and the Race that Will Change the World. St. Martin’s Press. ISBN 978-1250337740

P, Deepak. 2024. Mere imitation. Aeon. 08-08-2024. https://aeon.co/essays/is-ai-our-salvation-our-undoing-or-just-more-of-the-same

Piper, Kelsey. 2025. The AI that apparently wants Elon Musk to die. Vox. 28-02-2025. https://www.vox.com/future-perfect/401874/elon-musk-ai-grok-twitter-openai-chatgpt

Raitlif, Evan. 2025. The Delirious, Violent Impossible, True Story of the Zizians. Wired. 21-02-2025. https://www.wired.com/story/delirious-violent-impossible-true-story-zizians/

Rampony, Mark. 2023. The full story of large language models and RLHF. AssemblyAI. 03-05-2023. https://assemblyai-new.webflow.io/blog/the-full-story-of-large-language-models-and-rlhf

Roser, Max. Our World in Data. 2022. The brief history of artificial intelligence: the world has changed fast – what might be next?. Our World in Data. 06-12-2022. https://ourworldindata.org/brief-history-of-ai#article-citation

Russell, Stuart J. 2019. Human Compatible: Artificial Intelligence and the Problem of Control. Viking, 2019. ISBN 978-0525558637

Shannon, Claude E. a Weaver, Warren. 1963. The Mathematical Theory of Communication. Urbana, IL: University of Illinois Press, 1963. ISBN 978-0-252-72548-7.

Sobel, David. 2008. Childhood and Nature: Design Principles for Educators. Stenhouse Publishers, 2008. ISBN 978-1571107411

Vincent, Brandi. 2023. What the Pentagon Can Learn from the Saga of the Rogue AI-Enabled Drone Thought Experiment. DefenseScoop. 14-06-2023. https://defensescoop.com/2023/06/14/what-the-pentagon-can-learn-from-the-saga-of-the-rogue-ai-enabled-drone-thought-experiment/

Webster, Graham, Creemers, Rogier, Kania, Elsa a Triolo, Paul.. 2017. China’s new generation artificial intelligence development plan. Stanford DigiChina. 01-08-2017. https://digichina.stanford.edu/work/full-translation-chinas-new-generation-artificial-intelligence-development-plan-2017/

Whitaker, Jason. 2019. Tech Giants, Artificial Intelligence, and the Future of Journalism. Routledge – Taylor & Francis. ISBN 978-1-138-49997-3

Wintjen, Hendrik. 2018. Erwin Schrödinger: There is only one mind. Hendrik-Wintjen.info. 14-09-2018. https://www.hendrik-wintjen.info/consciousness/erwin-schroedinger-one-mind/

Yudkowsky, E. 2023. Pausing AI Developments Isn’t Enough. We Need to Shut it All Down. TIME. 29-03-2023. https://time.com/6266923/ai-eliezer-yudkowsky-open-letter-not-enough/